Perceptrons & Multi-Layer Perceptrons: the Artificial Neuron - MissingLink

Learn about the artificial neuron at the core of deep learning—how a perceptron works, and how they are used in real neural network projects.

missinglink.ai

The multilayer perceptron has another, more common name—a neural network.

전에 봤던 단층 퍼셉트론을 여러 층(layer)을 쌓으면 다층 퍼셉트론이라고 하는데 이를 보통 신경망(neural network)이라 부릅니다.

여기서 아주 중요한 활성화 함수(Activation function)이 등장합니다.

활성화 함수란 입력 신호의 총합을 출력 신호로 변환하는 함수를 의미합니다.

사실 퍼셉트론에서 b + w1x1 + w2x2를 0 혹은 1로 변환한 것도 활성화 함수입니다.

여러 활성화 함수 중 계단 함수를 사용했던건데 신경망에서는 다른 종류의 활성화 함수를 사용할 예정입니다.

그리고 이 부분이 중요한 특징이 됩니다.

missinglink.ai/guides/neural-network-concepts/7-types-neural-network-activation-functions-right/

7 Types of Activation Functions in Neural Networks: How to Choose?

Understand the evolution of different types of activation functions in neural network and learn the pros and cons of linear, step, ReLU, PRLeLU, Softmax and Swish.

missinglink.ai

해당 사이트에서 기본적인 활성화 함수에 대한 설명과 대표적인 활성화 함수들을 소개하고 있습니다.

1. Binary Step Function(계단함수)

퍼셉트론에서 사용했던 계단함수입니다.

출력값이 다양하지 않다는 단점이 있습니다.

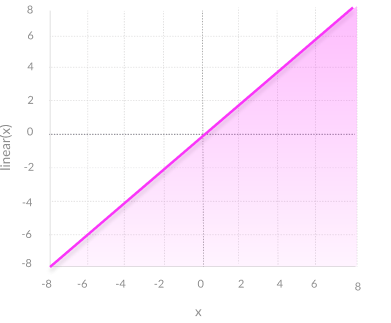

2. Linear Activation Function

이런 형식으로 생겼습니다.

한계점이 분명하기 때문에 활성화 함수로써 사용되지 않습니다.

1. 오차역전법을 할 수 없습니다.

2. 아무리 층(layer)을 쌓아봤자 결국 하나의 층이 됩니다.

3. Non-Linear Activation Functions

사실상 오늘의 메인 내용입니다.

Sigmoid, ReLU, tan h, Leaky ReLU, softmax 등 여러 함수가 있는데 중요한 내용이니 다음 포스팅에서 같이 알아보도록 하겠습니다.

+

sdolnote.tistory.com/entry/Linearity

선형이라는 것의 의미 (Linear 하다는 것의 의미)

대학에서 수학을 배우다 보면, 선형이라는 말 또는 linear하다는 말을 굉장히 많이 듣게 될 것이다. 하지만 나의 경우는 이런 말을 들을 때마다 상당히 불편했다. 선형이라는 것은 개념상 직선을

sdolnote.tistory.com

이게 여기에 맞는 내용일지는 모르지만 Linear 하다의 의미를 찾다가 발견한 글입니다.

단순히 직선이라는 의미 외에 어떤 의미를 갖고 있는지 설명되어 있습니다.

궁금하시면 한번 들려보세요 :D

'DATA STUDY > 밑바닥부터 시작하는 딥러닝' 카테고리의 다른 글

| 밑시딥 - 시그모이드 함수(Sigmoid function) (0) | 2021.03.16 |

|---|---|

| 밑시딥 - 퍼셉트론의 한계 (0) | 2021.03.06 |

| 밑시딥 - 퍼셉트론 구현(가중치와 편향) (0) | 2021.03.06 |

| 밑시딥 - 단순한 논리 회로(AND, NAND, OR) (0) | 2021.03.04 |

| 밑시딥 - 퍼셉트론(Perceptron)이 뭘까? (0) | 2021.03.04 |